WhisperSpeech是一个开源的文本到语音系统,其最大的亮点是通过对OpenAI的Whisper语音识别模型进行反向工程,实现了接收文本输入,并利用修改后的Whisper模型生成听起来自然的语音输出。WhisperSpeech的语音输出在发音准确性和自然度方面都非常出色。

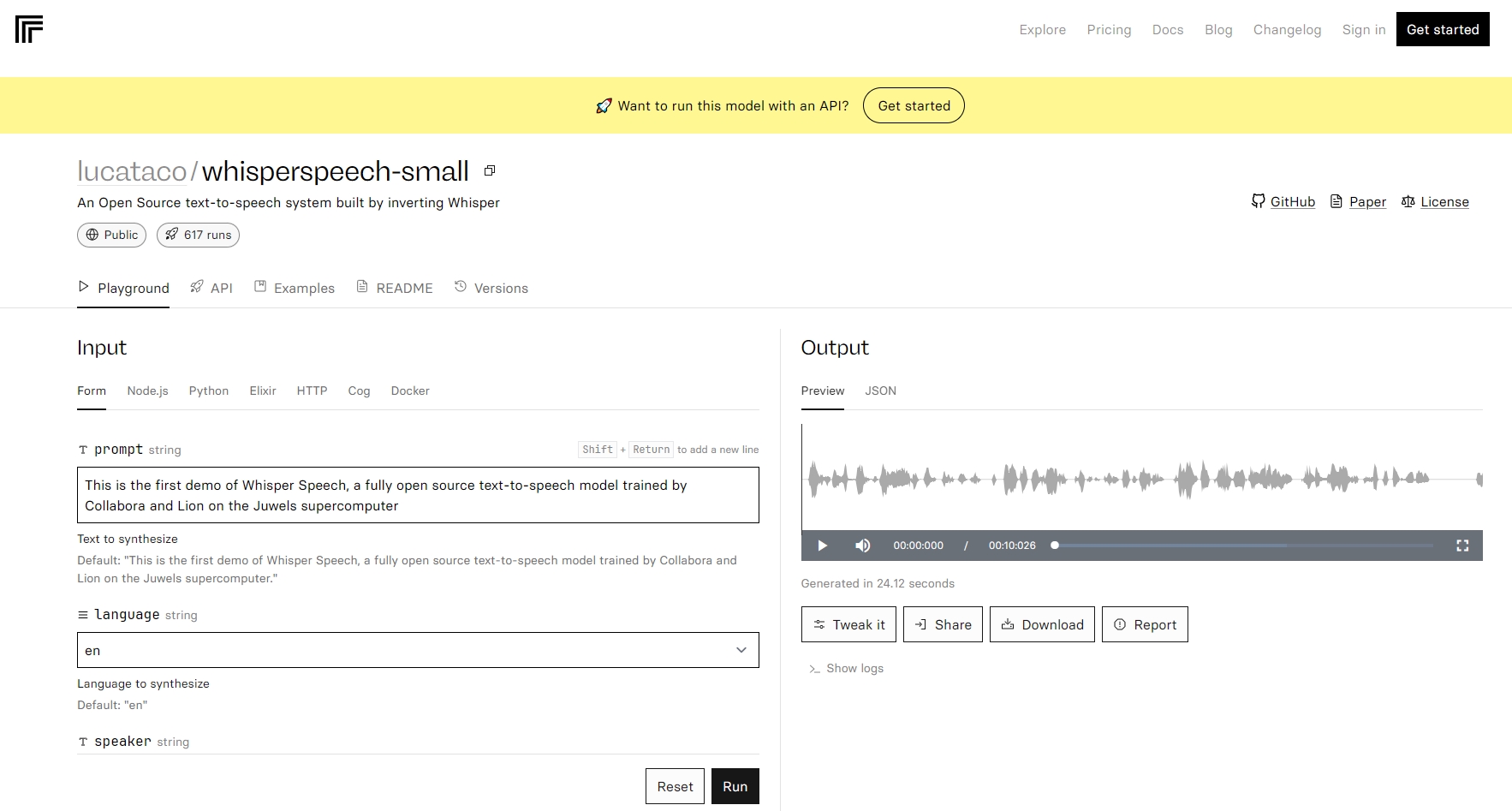

体验地址:https://replicate.com/lucataco/whisperspeech-small

Github:https://github.com/lucataco/cog-whisperspeech

目前,WhisperSpeech模型是在英语LibreLight数据集上训练的,但下一个版本的目标是多种语言(Whisper和EnCodec都是多语言的)。系统还可以在单个句子中混合多种语言,并且增加了测试语音克隆的简便方法。

WhisperSpeech 项目路线图:

-声学标记提取:改进声学标记的提取过程。

-语义标记提取:使用Whisper模型生成和量化语义标记。

-S-gt;A模型转换:开发将语义标记转换为声学标记的模型。

-T-gt;S模型转换:实现从文本标记到语义标记的转换。

-提升EnCodec语音质量:优化EnCodec模型以提高语音合成质量。

-短句推理优化:改善系统处理短句的能力。

-扩展情感语音数据集:收集更大的情感语音数据。

-文档化LibriLight数据集:详细记录HuggingFace上的数据集。

-多语言语音收集:聚集社区资源,收集多种语言的语音。

-训练多语言模型:开发支持多语言的文本到语音模型。