MVGFormer:用于3D人体姿态估计的多视角几何Transformers

在计算机视觉和机器学习领域,3D 人体姿态估计是一项具有挑战性的任务,因为它要求算法能够从图像或视频中准确地预测出人体关节的 3D 空间位置。这项技术对于深入理解人类行为、增强现实、虚拟现实、游戏动画以及人机交互等领域具有重要的应用潜力。然而,现有的基于深度学习的方法在处理多视角数据时,常常面临遮挡问题和视角变化所带来的挑战,特别是在准确解析几何信息方面仍显不足。

尽管目前的研究已经通过使用神经网络,在 3D 人体姿态估计上取得了进步,但这些方法在多视角设置中,尤其是在训练阶段未遇到的新视角和环境条件下,其性能表现往往不尽如人意。此外,现有的基于 Transformers 的端到端学习方法虽然能够处理遮挡问题,但在新场景下的泛化性能往往较差。因此,如何在保持端到端学习优势的基础上,提升模型对于新视角和遮挡情况的泛化能力,是当前研究面临的关键课题。

为了解决这个问题,研究员们提出了一种新的方法,其主要思想可以概括为以下三个部分:

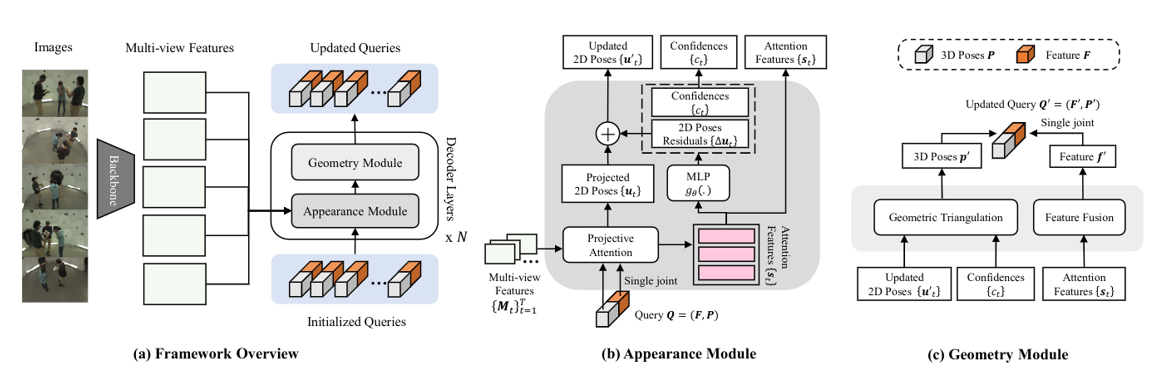

1)混合模型设计:研究员们提出了一种新颖的混合模型 MVGFormer,该模型结合了几何模块和外观模块。几何模块负责处理所有与视角相关的 3D 任务,而外观模块则专注于从图像信号中估计 2D 姿态。

2)迭代细化过程:MVGFormer 通过迭代的方式,交替使用外观模块和几何模块来细化 2D 和 3D 姿态。外观模块基于图像特征预测2D姿态,几何模块利用三角测量法从 2D 姿态中恢复 3D 姿态。

3)端到端训练与评估:MVGFormer 支持端到端的训练,因此研究员们能通过一系列训练目标和损失函数来优化模型。在训练过程中,模型将学习如何准确地从一组初始化查询中重建 3D 人体姿态。

实验结果表明,相较于目前领域内的前沿方法,MVGFormer 在多种测试条件下均展现出了卓越的性能,特别是在那些训练阶段未曾遇到的新视角下,其表现尤为突出。这一成就主要得益于 MVGFormer 强大的泛化能力,即便在全新的视角条件下,它仍能保持对 3D 人体姿态的高精度估计,对于需要在多种视角下理解和预测人体动作的应用场景具有重要意义。

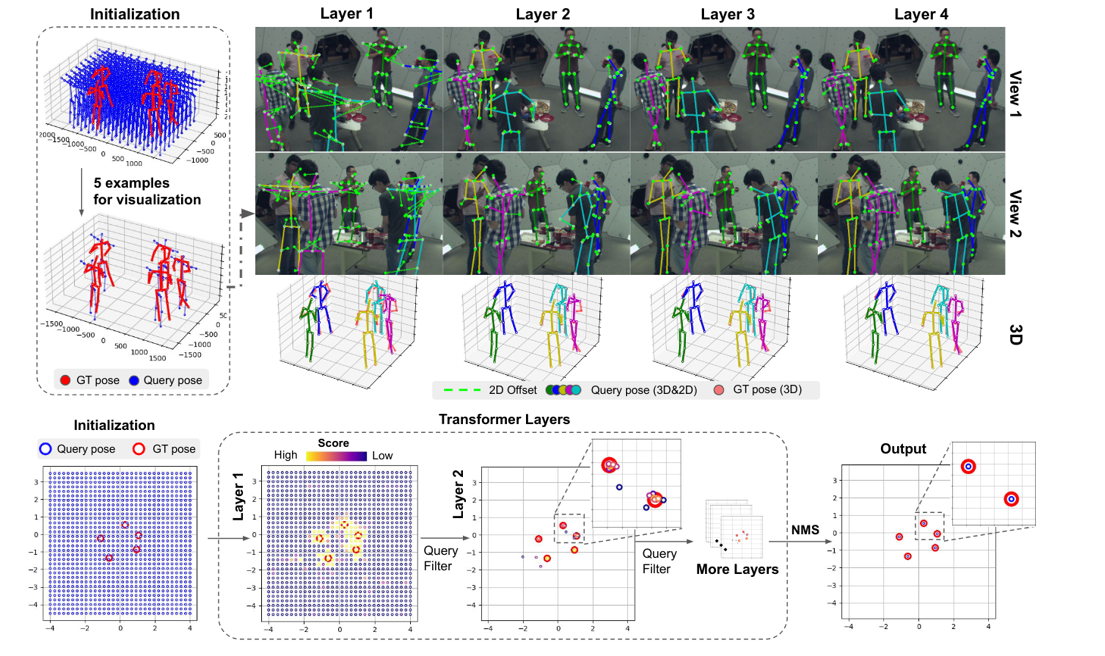

图6:MVGFormer 将初始化查询恢复出 3D 人体姿态的过程

此外,MVGFormer 的框架还具有通用性,可以应用于其他关键点估计任务,如形状、手部和面部估计。未来,研究员们也可能会探索将该架构扩展到基于视频的系统中,以利用时间信息实现更稳健的追踪。

论文链接:https://arxiv.org/abs/2311.10983

项目链接:https://github.com/XunshanMan/MVGFormer