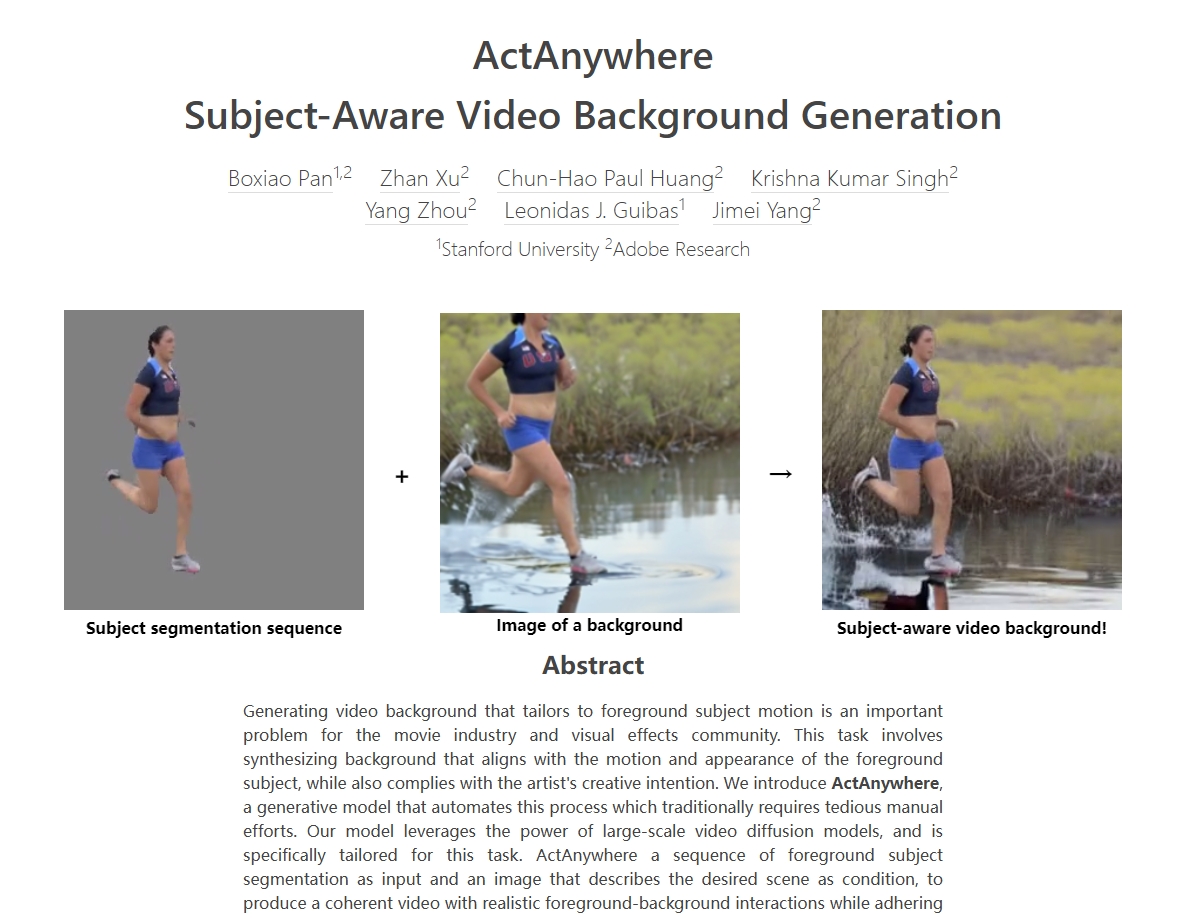

ActAnywhere是一个用于自动生成与前景主体运动和外观相符的视频背景的生成模型。该任务涉及合成与前景主体运动和外观相一致的背景,同时也符合艺术家的创作意图。ActAnywhere利用大规模视频扩散模型的力量,并专门定制用于此任务。ActAnywhere以一系列前景主体分割作为输入,以描述所需场景的图像作为条件,生成与条件帧相一致的连贯视频,同时实现现实的前景和背景交互。该模型在大规模人机交互视频数据集上进行训练。大量评估表明该模型的性能明显优于基准,可以泛化到各种分布样本,包括非人类主体。

链接:https://actanywhere.github.io/

需求人群:

"ActAnywhere可用于自动为包含人类或其他主体的视频生成相应的背景,从而减少手工调整的工作量,提高视频制作效率。"

使用场景示例:

- 使用包含人物运动的视频分割序列及海边图片,生成人物在海边奔跑的合成视频

- 使用包含舞蹈动作的视频分割和古代宫殿的图片,生成舞蹈在宫殿里进行的效果

- 使用汽车行驶的视频分割和高楼大厦的图片,生成汽车在城市街景行驶的效果

产品特色:

- 根据输入的前景主体分割序列,可以生成符合条件图像的视频背景

- 生成的背景会与前景主体运动和外观相协调

- 支持以合成的包含主体的帧或者仅包含背景的帧作为条件图像

- 可以生成具有不同摄像机运动的视频背景