在机器学习领域,“剪枝”是一种优化模型复杂度、降低过拟合风险并提升模型泛化能力的重要技术。其核心思想是通过移除模型中不重要或冗余的部分(如神经元、权重或决策树的节点),从而简化模型结构,减少计算资源消耗,同时保持甚至提升模型性能。

剪枝的主要类型

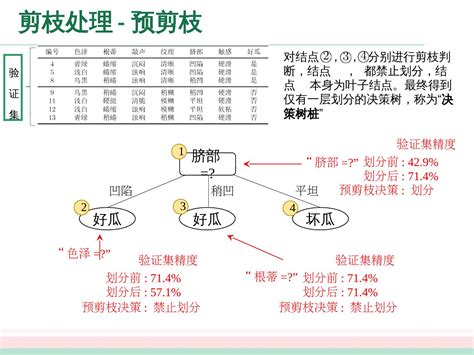

- 预剪枝(Pre-pruning)

预剪枝是在模型训练过程中提前终止某些分支的生长,以避免模型过于复杂。例如,在决策树中,可以通过限制树的最大深度、最小样本数或最小信息增益来实现预剪枝。这种方法可以减少训练时间和内存占用,但可能会导致欠拟合的风险。 - 后剪枝(Post-pruning)

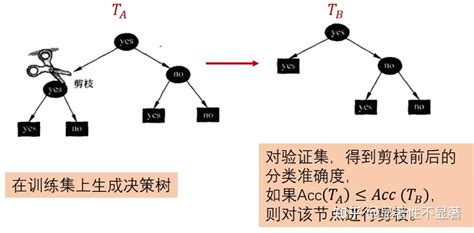

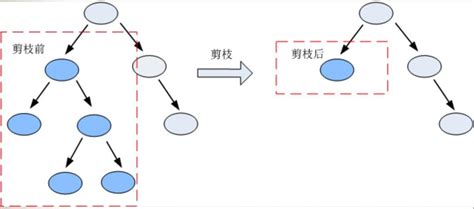

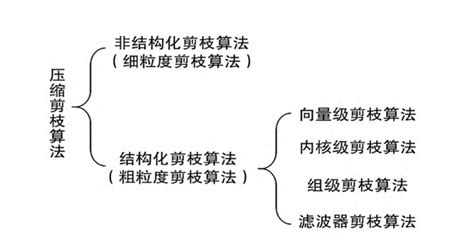

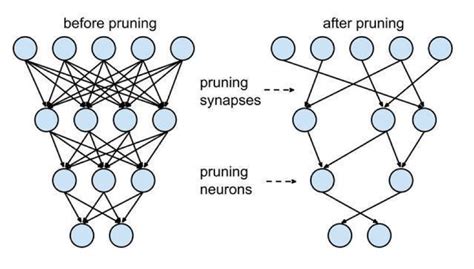

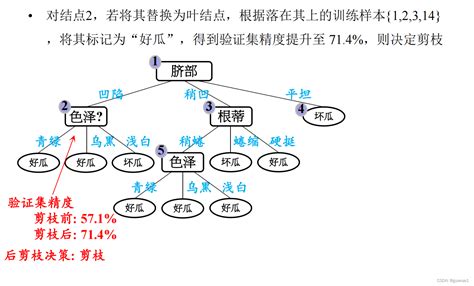

后剪枝是在模型完全训练完成后,通过删除不必要的节点或连接来简化模型。例如,在决策树中,可以通过删除预测误差最小的叶子节点或替换为父节点来实现后剪枝;在神经网络中,可以通过移除权重较小的神经元或连接来减少复杂度。 - 结构化剪枝与非结构化剪枝

- 正则化剪枝

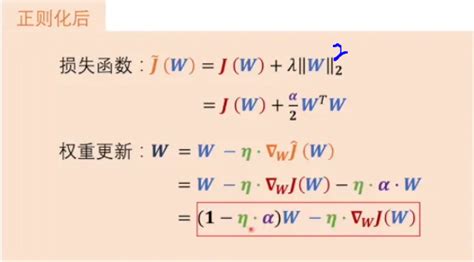

正则化剪枝通过在损失函数中加入惩罚项(如L1或L2范数),促使模型生成更简单的结构。这种方法可以自动剪枝,同时保持模型的稀疏性。 深度学习入门笔记-12正则化-权重衰减

深度学习入门笔记-12正则化-权重衰减

剪枝的应用场景

- 决策树

剪枝是决策树学习中的重要技术,用于防止过拟合和降低计算复杂度。例如,通过删除某些子树或叶节点,可以简化模型并提高泛化能力。 决策树的剪枝_决策树剪枝-CSDN博客

决策树的剪枝_决策树剪枝-CSDN博客 - 神经网络

神经网络中的剪枝技术包括权重剪枝、神经元剪枝和滤波器剪枝等。这些技术可以显著减少模型大小和计算量,适用于边缘设备和实时应用。 - 支持向量机(SVM)和K近邻算法(KNN)

在这些算法中,剪枝可以减少数据集规模,降低计算复杂度,并提高算法效率。 - 集成学习

剪枝技术还可以应用于集成学习中,通过移除部分弱学习器来降低模型复杂度,同时保持预测性能。

剪枝的优势与挑战

- 优势:

- 减少计算量和存储需求。

- 提高模型的运行效率和推理速度。

- 避免过拟合,提升泛化能力。

- 降低模型部署成本,特别是在资源受限的设备上。

- 挑战:

- 如何平衡模型复杂度和泛化能力。

- 剪枝可能导致模型性能下降,需要仔细评估剪枝前后的效果。

- 结构化剪枝需要重新训练以恢复性能,而非结构化剪枝可能引入稀疏性问题。

总结

剪枝是一种广泛应用于机器学习领域的优化技术,其主要目的是通过移除冗余部分来简化模型结构,降低计算复杂度和存储需求,同时保持甚至提升模型性能。无论是决策树、神经网络还是其他算法,剪枝都可以有效应对过拟合问题,并提高模型的泛化能力和运行效率

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!