Q-learning算法是一种基于值的强化学习算法,其核心目标是通过与环境的交互学习最优策略,从而最大化长期累积奖励。它属于无模型(model-free)的强化学习方法,不需要显式地建模环境,而是直接从经验中学习状态-动作对的价值函数(Q函数)。

Q-learning算法的基本原理

- Q函数:Q-learning算法通过学习一个动作价值函数 Q(s,a),该函数表示在状态 下采取动作 的期望回报。Q函数可以理解为在当前状态下执行某个动作的潜在收益。

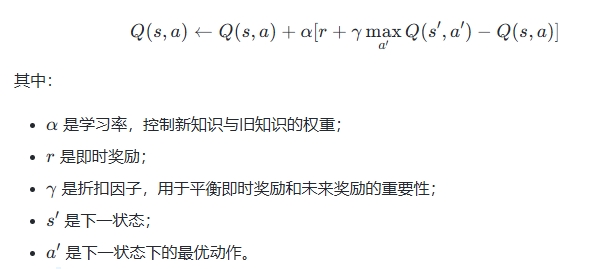

- 更新规则:Q-learning使用Bellman最优方程来更新Q值。具体来说,Q值的更新公式为:

- 贪婪策略:在选择动作时,通常采用ε-贪婪策略,即以一定概率 ϵ 随机选择动作,以探索环境;否则选择当前状态下Q值最大的动作,以利用已有的知识。

Q-learning算法的特点

- 离线学习:Q-learning是一种离线算法,不需要实时与环境交互,因此在某些场景下比在线算法更易于实现。

- 灵活性:由于不需要显式建模环境,Q-learning可以应用于各种复杂的决策问题,如自动驾驶、路径规划等。

- 收敛性:在某些条件下,Q-learning能够收敛到最优策略,但其收敛速度可能较慢,并且受初始Q值、学习率和折扣因子的影响较大。

Q-learning算法的应用

- 游戏AI:Q-learning被广泛应用于游戏领域,例如在Atari游戏中的应用。

- 自动驾驶:通过学习最优路径规划策略,Q-learning可以用于自动驾驶车辆的导航。

- 机器人控制:在机器人路径规划和任务分配中,Q-learning能够帮助智能体优化行为策略。

- 生物医学研究:在生物力学和运动意图识别等领域,Q-learning也被用于建模和分析复杂行为。

Q-learning算法的改进与扩展

- 深度Q网络(DQN) :结合深度学习技术,DQN通过神经网络近似Q函数,解决了传统Q-learning在高维状态空间中的计算问题。

- 保守Q学习(CQL) :为了解决传统Q-learning在分布偏移下的过估计问题,CQL引入了保守估计方法。

- 双Q学习(Double Q-learning) :通过引入两个Q网络来减少过估计现象,提高了算法的稳定性和性能。

总结

Q-learning算法是一种强大的强化学习工具,适用于多种复杂决策问题。它通过迭代更新Q值函数,逐步逼近最优策略。尽管其在某些情况下可能面临收敛速度慢或过估计的问题,但通过改进和扩展(如DQN、CQL等),Q-learning仍然是现代强化学习领域的重要基石之一

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!