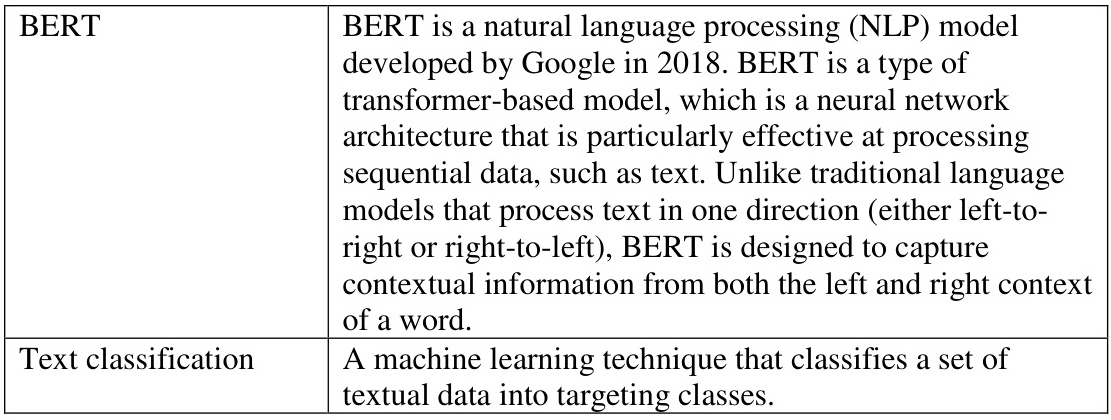

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer架构的预训练语言模型,由Google在2018年提出。其核心思想是通过双向编码器捕捉文本中的上下文信息,从而生成深度双向的语言表示。

BERT的主要特点:

- 双向编码器:与传统的单向语言模型不同,BERT能够同时利用左右两侧的上下文信息,从而更好地理解词语的含义。

- 预训练与微调:BERT采用两阶段训练策略:

- Transformer架构:BERT基于Transformer的编码器部分,利用自注意力机制和多头注意力机制来处理输入文本。

- 位置嵌入:BERT通过位置嵌入捕捉序列中单词的位置信息,避免了传统模型中依赖于固定顺序的问题。

- 大规模语料库:BERT的预训练使用了超过25亿个维基百科页面和8亿个谷歌网页的文本数据,这为模型提供了丰富的语言知识。

BERT的应用:

BERT在多个自然语言处理任务中表现出色,包括但不限于:

BERT的优势:

- 强大的上下文理解能力:由于其双向编码器,BERT能够更全面地理解句子中的语义关系。

- 灵活性高:只需在预训练的基础上添加少量任务特定的层,即可适应多种下游任务。

- 性能优越:在多个基准测试中超越了当时的最佳模型,例如在GLUE和SQuAD任务中取得了显著成绩。

BERT的局限性:

尽管BERT在许多任务中表现优异,但它也存在一些局限性:

- 计算资源需求高:由于其复杂的Transformer架构,BERT需要大量的计算资源进行训练。

- 生成任务表现不佳:BERT在生成任务(如文本生成)上的表现不如专门设计的生成模型。

总结:

BERT是一种革命性的语言模型,通过双向编码器和大规模预训练,显著提升了自然语言处理任务的性能。其灵活的微调机制使其能够广泛应用于各种NLP任务中,成为当前NLP领域的核心技术之一

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!