激活量化(Activation Quantization)是深度学习模型优化中的一种重要技术,其主要目的是将神经网络中的激活值从高精度(如32位浮点数)转换为低精度表示(如8位整数),从而减少模型的存储需求和计算开销。这种技术广泛应用于模型压缩、推理加速以及硬件优化等领域。

激活量化的定义与目的

激活量化是指对神经网络中每一层的激活值进行量化处理,即将这些激活值从高精度浮点数(如FP32)转换为低精度整数(如INT8)。通过这种方式,可以显著降低模型的内存占用和计算复杂度,同时提升推理速度。

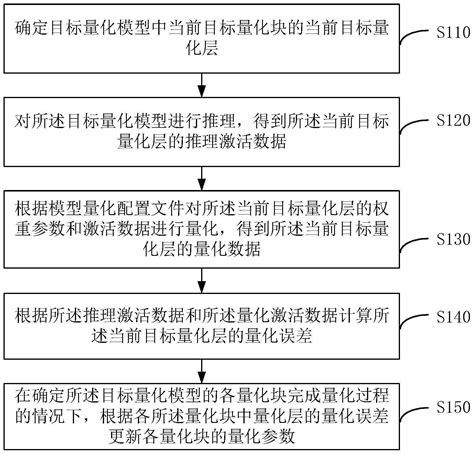

一种模型量化方法与流程

激活量化的分类

激活量化的方法可以根据是否需要训练阶段的参与以及量化方式的不同分为以下几类:

- 静态量化:

- 在模型训练完成后,通过校准数据集计算出固定的量化参数(如缩放因子和零点),然后对激活值进行一次性量化。这种方法简单高效,但可能无法适应输入数据的变化。

- 动态量化:

- 动态量化是在推理阶段根据输入数据的实时分布动态调整量化参数。这种方法能够适应不同的输入数据,但计算开销较大。

- 训练后量化(Post Training Quantization, PTQ):

- PTQ是一种常见的激活量化方法,它不需要重新训练模型,只需在训练完成后通过校准数据集计算量化参数即可完成量化。

- 量化感知训练(Quantization Aware Training, QAT):

- QAT在模型训练过程中同时进行权重和激活的量化,通过模拟量化带来的误差来优化模型性能。这种方法能够在推理阶段获得更好的精度。

- 非线性量化与线性量化:

- 非线性量化通过非线性映射将激活值映射到有限整数集合中,例如伽马压缩(Gamma Compression);线性量化则通过线性映射实现,例如均值裁剪(Mean Remapping)。

激活量化的实现方法

激活量化的具体实现方法包括以下几种:

- INT4量化:

- INT4量化是一种常见的激活量化方法,将激活值从32位浮点数压缩到4位整数。其过程包括计算缩放因子和偏移量,并通过clip操作避免数值溢出。

- 有界整流单元(BreLU)量化:

- 查表法与泰勒展开法:

- 查表法适用于运算性能较低的设备,通过预先计算非线性激活函数的值并存储在表格中;泰勒展开法则通过近似计算非线性函数来实现量化。

- KL对称量化:

- KL对称量化通过最小化真实数据分布与量化数据分布之间的KL散度来确定量化阈值,从而减少精度损失。

激活量化的优缺点

优点:

- 减少模型大小和存储需求。

- 提升推理速度,特别是在硬件加速器上运行时效果显著。

- 降低通信成本,适用于分布式训练环境。

缺点:

- 过度压缩可能导致模型精度下降。

- 动态量化需要额外的计算资源。

- 非线性激活函数的量化较为复杂,可能需要额外的优化。

激活量化的应用场景

激活量化广泛应用于以下场景:

- 模型部署:在边缘设备或嵌入式系统上部署模型时,激活量化可以显著减少模型大小和推理时间。

- 硬件优化:通过低精度计算提升硬件利用率和能效比。

- 实时目标检测:在实时目标检测任务中,激活量化可以减少延迟并提高检测精度。

总结

激活量化是深度学习模型优化的重要手段之一,通过将激活值从高精度转换为低精度表示,可以显著减少模型的存储需求和计算开销。然而,由于激活值的动态性和非线性特性,激活量化的实现需要结合具体场景选择合适的量化方法。例如,在推理阶段使用静态或动态量化,在训练阶段使用QAT等方法。这些技术不仅提升了模型的效率,还为硬件优化和模型部署提供了更多可能性

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!