核范数正则化(Nuclear Norm Regularization)是一种在机器学习、深度学习和优化问题中广泛应用的正则化技术,其核心思想是通过约束矩阵的秩或奇异值来实现低秩性,从而减少模型的复杂度,提高泛化能力。以下是关于核范数正则化的详细解释:

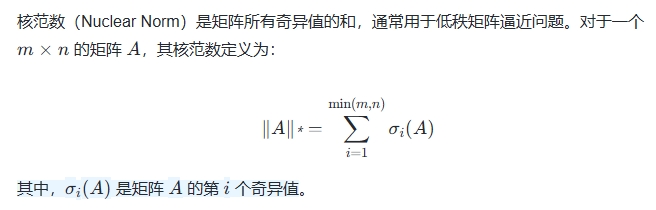

核范数的定义

核范数可以视为矩阵的“范数”形式,与传统的向量范数(如 L1、L2 范数)不同,核范数关注的是矩阵的秩而非向量的长度。

核范数正则化的原理

核范数正则化的主要目的是通过最小化矩阵的核范数来约束模型的复杂度,从而避免过拟合。具体来说,核范数正则化通过以下方式实现:

- 低秩约束:核范数正则化倾向于选择秩较低的矩阵,这在处理低秩矩阵问题(如矩阵补全、图像去噪等)时非常有效。

- 凸松弛:核范数是秩函数的凸松弛,能够有效地近似低秩约束,同时避免了非凸优化问题带来的计算困难。

- 稀疏性:核范数正则化可以诱导矩阵的稀疏性,即通过减少奇异值的数量来降低矩阵的复杂度。

核范数正则化的应用场景

核范数正则化在多个领域有广泛应用:

- 图像处理:用于图像去噪、图像恢复和图像补全。例如,在图像补全任务中,核范数正则化能够有效提取图像的核心信息,同时去除噪声。

- 机器学习:用于增强模型的泛化能力,特别是在处理高维数据时。例如,在域泛化任务中,核范数正则化能够显著提高模型性能。

- 多元回归:在多元回归模型中,核范数正则化可以用于估计自由度并提高模型的一致性。

- 矩阵补全:通过最小化核范数来完成缺失数据的估计。

核范数正则化的优缺点

优点:

- 低秩性:核范数正则化能够有效降低矩阵的秩,从而减少模型的复杂度。

- 凸松弛:核范数是秩函数的凸松弛,优化问题更容易求解。

- 泛化能力:通过约束模型复杂度,核范数正则化有助于提高模型的泛化能力。

缺点:

核范数正则化的改进方法

为了克服核范数正则化的局限性,研究者提出了多种改进方法:

- 截断核范数(TNN) :通过截断部分奇异值来减少计算复杂度,同时保持较好的低秩逼近效果。

- 加权核范数(WNNM) :通过引入权重因子来调整不同奇异值的贡献,从而优化模型性能。

- 动态调整正则化参数:根据模型的恢复进展动态调整正则化参数,以平衡低秩性和数据拟合。

结论

核范数正则化是一种强大的正则化技术,广泛应用于低秩矩阵逼近、图像处理和机器学习等领域。尽管其计算复杂度较高,但通过改进方法(如截断核范数和加权核范数),可以有效降低计算成本并提升模型性能。核范数正则化在提高模型泛化能力和减少过拟合方面具有显著优势

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!