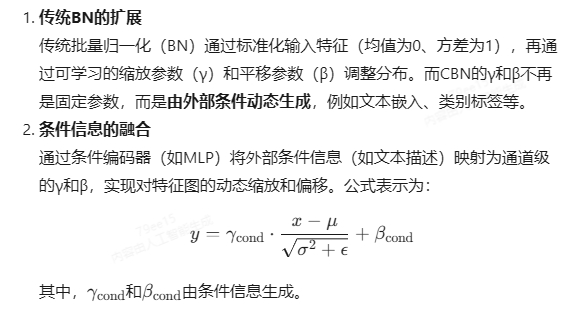

条件批量归一化(Conditional Batch Normalization, CBN)是一种结合外部条件信息(如文本、类别标签等)的归一化技术,主要用于增强生成模型或多模态任务中对特征图的动态控制能力。以下是其核心要点:

一、基本原理

二、实现方式

- 结构设计

- 训练与推理模式

- 训练时:使用当前批次的均值和方差进行归一化,并更新全局统计量(滑动平均)。

- 推理时:使用训练阶段积累的全局均值和方差,结合条件生成的γ和β输出结果。

三、应用场景

- 文本生成图像(如AttnGAN、SD-GAN)

- 通过自然语言描述中的语义线索(如语句级和词级信息)调节特征图,实现细粒度图像生成。

- 例如,SD-GAN利用CBN增强视觉语义嵌入,通过语言线索对特征图进行缩放、否定等操作。

- 多模态任务

- 在跨模态对齐中,CBN可作为条件生成对抗网络(cGAN)的核心组件,结合文本、语音等条件生成图像或视频。

四、优势与挑战

- 优势

- 挑战

- 条件编码有效性:若条件信息与特征图语义不匹配,可能导致生成效果偏差。

- 复杂场景限制:对包含多对象的复杂图像生成时,需结合其他模块(如注意力)提升效果。

五、典型应用案例

- SD-GAN:首次将CBN应用于文本生成图像,通过语言线索调节视觉特征,支持语句级和词级控制。

- 条件图像编辑:在图像风格迁移中,CBN通过风格标签动态调整特征图,实现多样化输出。

总结

CBN通过动态生成归一化参数,实现了外部条件与特征分布的高效融合,尤其在生成模型和多模态任务中表现突出。其核心价值在于平衡了条件控制的灵活性与计算效率,但需注意条件编码的质量与任务适配性。更多实现细节可参考论文《Batch Normalization: Accelerating Deep Network Training》及相关开源代码。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!