条件实例归一化(Conditional Instance Normalization,CIN)是一种结合条件信息与实例归一化的深度学习技术,主要用于生成模型和多模态任务(如图像风格迁移)。以下从核心原理、应用场景及技术对比三个方面展开说明:

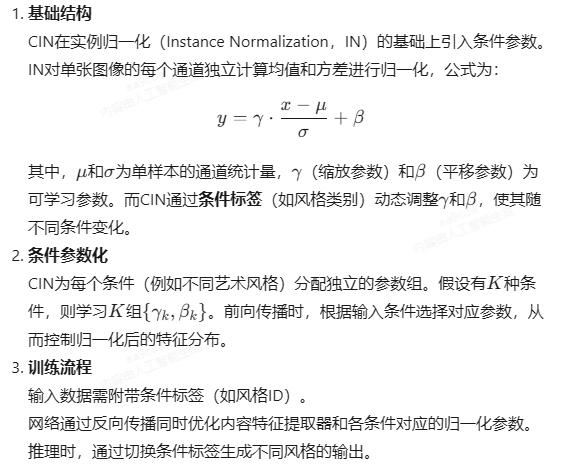

一、核心原理

二、应用场景

-

图像风格迁移

在艺术风格迁移任务中,CIN允许单一模型支持多种风格。例如,为每种风格训练一组参数,通过切换条件标签实现风格多样化输出,克服了传统方法需为每种风格单独训练模型的限制。 -

多模态生成

在生成对抗网络(GANs)中,CIN可用于控制生成图像的属性(如表情、光照),通过条件标签引导生成过程,提升生成结果的多样性和可控性。 -

语音与文本处理

在语音合成或文本生成任务中,CIN可结合说话人ID或语言类别,调整声学特征或语言模型的输出分布。

三、技术对比

- 与AdaIN的区别

- CIN:依赖预定义的条件标签,需在训练阶段学习各条件的固定参数,适合离散条件(如有限风格集合)。

- AdaIN:通过编码器实时计算风格图像的统计量(均值和方差),动态调整归一化参数,支持任意风格但需额外风格编码网络。

- 与动态归一化的区别

- 动态实例归一化(DIN):使用卷积网络预测归一化参数,而非依赖固定条件标签,更适合连续或未见的条件。

- CIN:参数与条件一一绑定,扩展性受限但训练更稳定。

四、优势与局限

- 优势

- 显式解耦内容与条件信息,提升模型可控性。

- 参数学习简单,适合小规模离散条件场景。

- 局限

- 条件数量固定,无法处理未知或连续条件。

- 参数存储量随条件类别线性增长,可能增加模型复杂度。

五、代码示例(简化版)

import torch.nn as nn

class ConditionalInstanceNorm(nn.Module):

def __init__(self, num_features, num_conditions):

super().__init__()

self.num_conditions = num_conditions

self.gamma = nn.Parameter(torch.randn(num_conditions, num_features))

self.beta = nn.Parameter(torch.zeros(num_conditions, num_features))

def forward(self, x, condition_id):

# x: [B, C, H, W], condition_id: [B]

gamma = self.gamma[condition_id].unsqueeze(-1).unsqueeze(-1) # [B, C, 1, 1]

beta = self.beta[condition_id].unsqueeze(-1).unsqueeze(-1)

# 实例归一化

mean = x.mean(dim=(2, 3), keepdim=True)

var = x.var(dim=(2, 3), keepdim=True, unbiased=False)

x_norm = (x - mean) / torch.sqrt(var + 1e-5)

return gamma * x_norm + beta

如需进一步了解具体实现或应用案例,可参考原始论文或代码库(如PyTorch的torch.nn.InstanceNorm 扩展)。