权重剪枝(Weight Pruning)是一种深度学习模型优化技术,旨在通过移除神经网络中不重要的权重参数来简化模型,从而减少模型的复杂度和计算资源消耗。这种方法的核心思想是识别并移除那些对模型最终输出影响较小的权重,这些权重通常被认为是冗余或不重要的。

权重剪枝的基本原理

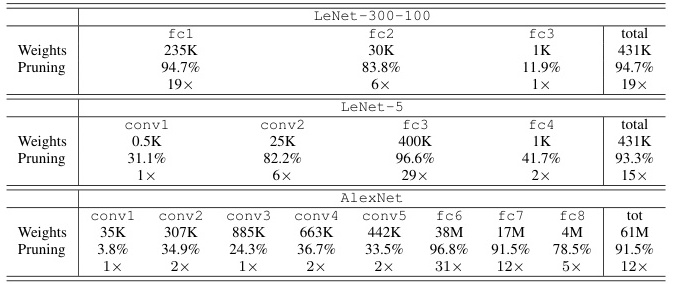

- 定义:权重剪枝通过移除权重矩阵中绝对值较小的权重,从而减少模型的参数量和计算量。例如,在LeNet-300模型中,通过剪枝可以保留大部分权重,同时显著减少参数数量。

- 目标:减少模型大小、降低推理时的计算负担,并节省硬件资源。

- 方法:权重剪枝通常包括以下步骤:

- 确定剪枝阈值:根据模型压缩的需求,设定一个权重阈值,低于该阈值的权重将被移除。

- 确定剪枝比例:根据模型压缩的目标,确定需要移除的权重比例。

- 寻找剪枝目标:遍历所有权重,标记绝对值小于阈值的连接。

- 权重新置与更新:将被剪枝的权重设置为0,并在后续训练过程中不再更新这些权重。

权重剪枝的分类

根据剪枝粒度和方式的不同,权重剪枝可以分为以下几种类型:

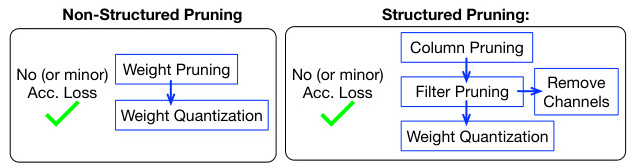

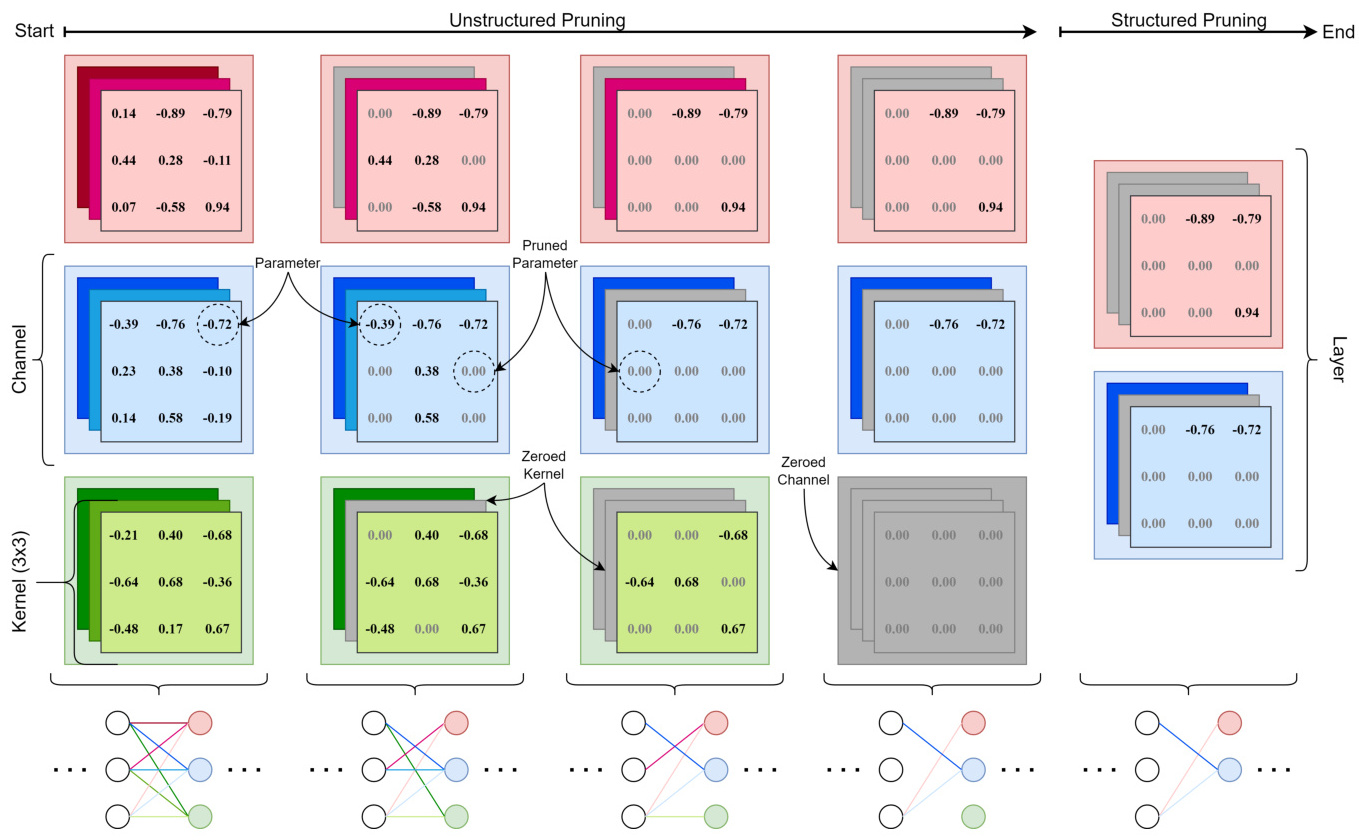

- 非结构化剪枝:直接从权重矩阵中移除不重要的权重,这会导致稀疏矩阵的生成。这种方法虽然简单高效,但生成的稀疏矩阵难以利用现有硬件加速器进行优化。

- 结构化剪枝:按照一定的规则移除整个滤波器、通道或层,从而保持稀疏矩阵的结构。这种方法更适合现代计算平台和框架,但需要更复杂的实现。

权重剪枝的优势与挑战

- 优势:

- 减少模型大小:通过移除冗余权重,模型的存储大小和计算量显著降低。

- 提高推理效率:减少计算负担,使得模型在低功耗设备上运行更加高效。

- 节省硬件资源:减少模型参数量,降低内存占用。

- 挑战:

- 模型精度损失:过度剪枝可能导致模型性能下降,因此需要在剪枝比例和模型精度之间找到平衡。

- 训练难度增加:剪枝后的模型可能需要重新训练以恢复精度。

- 硬件兼容性问题:非结构化剪枝生成的稀疏矩阵难以利用现有硬件加速器进行优化。

权重剪枝的应用场景

权重剪枝广泛应用于各种深度学习模型优化场景,包括但不限于:

- 边缘计算:通过剪枝技术减小模型大小,使其能够在资源受限的设备上运行。

- 模型部署:在模型上线前进行剪枝,以减少推理延迟和能耗。

- 硬件优化:结合硬件特性设计剪枝策略,以最大化性能提升。

实现工具与框架

目前,许多深度学习框架提供了权重剪枝的支持。例如:

- PyTorch:通过

torch.nn.utils.prune模块实现权重剪枝。 - msModelSlim:支持Transformer类模型的权重剪枝,并提供灵活的自定义配置。

总结

权重剪枝是一种有效的深度学习模型优化技术,通过移除不重要的权重参数来简化模型,从而减少计算资源消耗和提高运行效率。尽管其在减少模型大小和提高推理效率方面具有显著优势,但在实际应用中仍需注意平衡模型精度与剪枝比例的关系,并结合硬件特性进行优化设计。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!