层归一化(Layer Normalization,LN)是深度学习中一种重要的归一化技术,主要用于解决神经网络训练中的内部协变量偏移问题,通过稳定数据分布来加速模型收敛并提高泛化能力。以下是其核心要点:

一、基本原理与计算方式

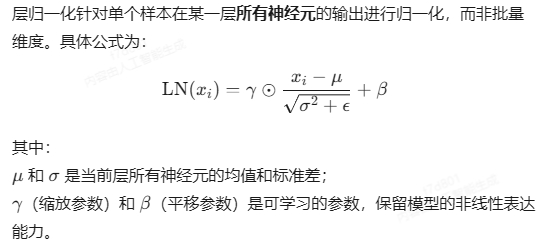

- 归一化对象

- 与批量归一化(BN)的区别

- BN:对同一批次中所有样本的同一特征维度进行归一化,依赖批次统计量,对小批量敏感;

- LN:对单个样本的所有特征维度进行归一化,独立于批次大小,更适合动态网络(如RNN、Transformer)。

二、核心作用

- 稳定训练过程

- 提升模型泛化能力

- 动态网络适配性

- 适用于RNN等动态结构,每个时间步可独立归一化,避免批量统计量在变长序列中的计算问题。

三、应用场景与优势

- NLP领域

- 小批量或单样本训练

- 不依赖批次统计量,在小批量或在线学习场景中表现稳定,优于BN。

- 对比其他归一化方法

- Instance Normalization:单样本单通道归一化,常用于图像风格迁移;

- Group Normalization:将通道分组后归一化,适合小批量CNN任务。

四、技术实现细节

- 训练与推断阶段

- 训练时:直接计算当前样本的均值和方差;

- 推断时:无需额外统计量,直接应用训练好的参数。

- 参数初始化

- γ 初始化为1,β 初始化为0,确保初始状态下归一化不改变原始分布。

五、局限性

- 特征间差异损失:对样本内所有特征统一归一化,可能削弱某些重要特征的区分度;

- 领域适应性:在CV任务中,BN因保留通道间差异通常更优,而LN更适配序列数据。

六、代码示例(PyTorch)

import torch.nn as nn

# 定义层归一化(输入特征维度为512)

layer_norm = nn.LayerNorm(512)

# 前向传播(输入维度:[batch_size, seq_len, 512])

output = layer_norm(input_tensor)

层归一化通过其样本内归一化的特性,成为处理动态网络和小批量训练的关键技术,尤其在NLP和序列模型中表现卓越。实际应用中需结合任务特点选择归一化方法。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!