什么是在线镜像下降(Online Mirror Descent )

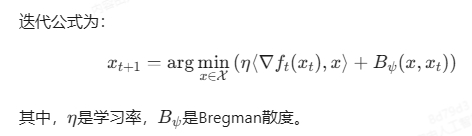

在线镜像下降(Online Mirror Descent, OMD)是一种在线凸优化算法,通过引入Bregman散度替代传统的欧氏距离投影,扩展了梯度下降的适用范围,特别适用于非欧几何空间(如概率单纯形)和动态学习率场景。以下是详细解析:

一、核心定义与数学形式化

-

基本思想

OMD是梯度下降的广义形式,其核心在于用Bregman散度替代梯度下降中的欧氏距离投影。Bregman散度由严格凸的可微函数生成,例如: -

与梯度下降的区别

- 投影方式:OMD通过Bregman散度进行隐式投影,梯度下降则使用欧氏投影。

- 适用空间:OMD可处理非欧结构(如概率分布空间),梯度下降仅适用于欧氏空间。

二、关键特点与优势

- 动态学习率适应性

- 在在线学习中,OMD通过对偶空间更新实现对动态学习率的适应,但需结合稳定化技术以避免线性遗憾(如动态学习率下的渐近性能差异)。

- 应用场景

- 与对偶平均(DA)的对比

- 相同点:当学习率固定时,OMD与DA具有相似的遗憾边界。

- 不同点:在动态学习率下,DA天然保证次线性遗憾,而OMD需额外稳定化技术避免线性遗憾。

三、局限性及改进方向

- 局限性

- 动态学习率挑战:未稳定化的OMD可能因学习率调整不当导致线性遗憾,需引入正则化或重启机制。

- 非凸优化扩展:传统OMD针对凸问题,非凸场景需结合惯性块更新或近端映射改进(如非凸复合优化中的块坐标下降法)。

- 改进方向

- 稳定化技术:如对偶稳定化OMD,确保动态学习率下的次线性遗憾。

- 复合优化扩展:结合近端算子处理非光滑目标函数(如在线对偶镜像下降算法中的次梯度更新)。

四、总结

在线镜像下降通过Bregman散度扩展了梯度下降的适用范围,成为在线凸优化的核心工具之一。其在资源分配、强化学习等场景的优异表现,依赖于对问题几何结构的适应性及动态学习率的优化设计。然而,动态环境下的稳定性和非凸扩展仍是未来研究的重要方向。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!