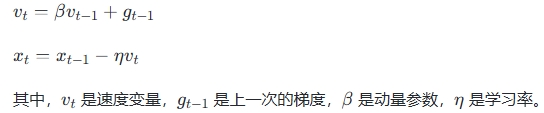

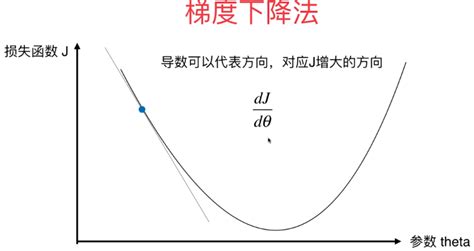

动量梯度下降法(Momentum Gradient Descent,MGD)是一种优化算法,用于改进传统的梯度下降法。其核心思想是通过计算梯度的指数加权平均数来更新权重,从而加速模型的收敛速度并减少振荡现象。

具体来说,动量梯度下降法引入了一个速度变量,该变量在每次迭代中不仅考虑当前的梯度方向,还继承之前更新的方向。这种方法类似于物理学中的惯性概念,使得优化过程具有一定的“惯性”,能够跨越狭长的山谷和局部最优点,朝着更优的方向前进。

动量梯度下降法的一个显著优点是它允许在遇到局部最优时继续前进,避免了传统梯度下降法中常见的振荡问题,并且通常比标准的梯度下降法运行得更快。这种方法特别适用于深度学习中的参数优化,因为它可以加速模型在复杂函数空间中的收敛过程

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!