信息NCE损失(InfoNCE Loss)是一种基于对比学习的损失函数,主要用于自监督学习和表示学习任务中。其核心思想是通过最大化正样本对之间的相似性,同时最小化负样本对之间的相似性,从而学习到有意义的特征表示。

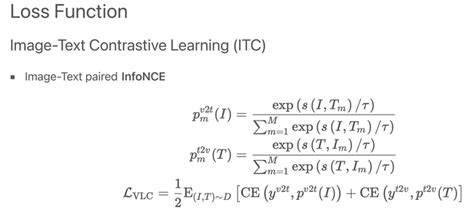

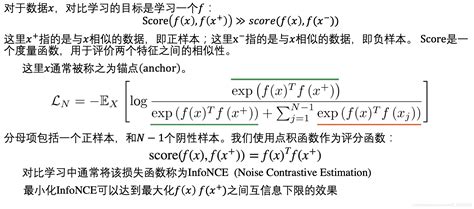

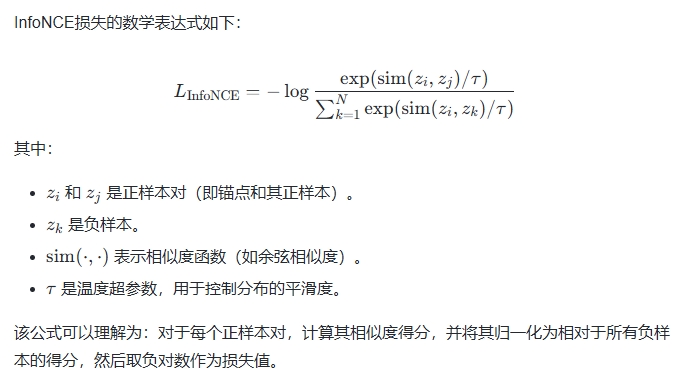

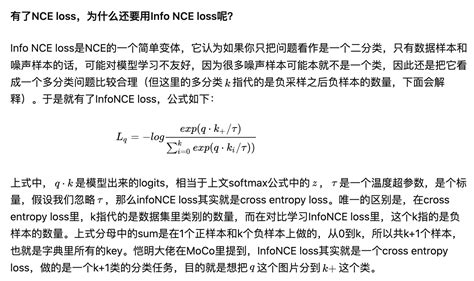

1. 定义与公式

2. 工作原理

InfoNCE损失通过以下方式实现对比学习的目标:

- 最大化正样本对的相似性:通过增加正样本对的相似度得分,优化模型以更好地捕捉正样本之间的关系。

- 最小化负样本对的相似性:通过降低负样本对的相似度得分,避免模型将噪声样本误认为正样本。

这种机制使得模型能够学习到区分性强的特征表示,从而提高下游任务的性能。

InfoNCE loss与交叉熵损失的联系,以及温度系数的作用_nce温度系数

3. 应用场景

InfoNCE损失广泛应用于以下领域:

- 自监督学习:如SimCLR、MoCo等框架中,用于无监督学习图像、文本或语音等数据的表示。

- 推荐系统:通过对比学习优化用户行为建模,提升推荐效果。

- 图像检索:在CLISAR-Net等模型中,用于提高图像检索的鲁棒性和准确性。

4. 与NCE损失的关系

InfoNCE损失是NCE损失(Noise Contrastive Estimation Loss)的一个特例或变体。NCE损失将多分类问题转化为二分类问题,而InfoNCE损失则进一步简化为k+1分类问题,即一个正样本对和多个负样本对。

两者的主要区别在于:

- 目标不同:NCE损失主要用于概率分布估计,而InfoNCE损失更关注于特征表示的学习和区分度。

- 计算复杂度:InfoNCE损失通过引入温度参数和负样本对数,降低了计算复杂度。

5. 温度参数的作用

温度参数τ在InfoNCE损失中起到关键作用:

- 当τ较大时,分布更加平滑,模型对负样本的区分度较低;

- 当τ较小时,分布更加尖锐,模型对负样本的区分度较高。

6. 优化与改进

为了进一步提升性能,研究者提出了多种改进方法:

- Soft-InfoNCE损失:通过引入权重项来显式建模负样本之间的潜在关系。

- 自适应采样策略:根据任务需求动态调整负样本的数量和比例。

- 去偏置方法:减少负样本对模型的影响,提高模型的泛化能力。

7. 总结

InfoNCE损失是一种高效且灵活的对比学习损失函数,通过最大化正样本对的相似性并最小化负样本对的相似性,帮助模型学习到区分性强的特征表示。其在自监督学习、推荐系统和图像检索等领域展现了强大的应用潜力

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!