任务感知注意力(Task-aware Attention)是一种在深度学习和计算机视觉领域中广泛使用的注意力机制,旨在通过动态调整模型的注意力分配来优化特定任务的性能。其核心思想是根据任务需求灵活地调整注意力权重,从而提高模型对目标特征的捕捉能力和分类精度。

任务感知注意力的定义与作用

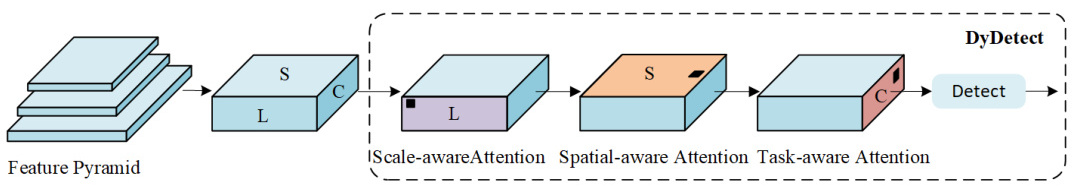

任务感知注意力机制通过学习控制阈值的超函数,动态调整通道的注意力权重。具体来说,它利用全局平均池化对特征进行降维,然后通过全连接层和归一化层对特征进行处理,并最终通过移位的sigmoid函数对输出进行归一化,从而实现对不同任务的自适应关注。这种机制能够根据任务的不同需求,动态地调整注意力分配,例如在目标检测任务中,它可以优先关注目标区域,而在分类任务中,则可能更关注全局特征。

任务感知注意力的应用

任务感知注意力机制被广泛应用于目标检测、分类、回归等多种任务中。例如,在DyHead(Dynamic Head)检测头中,任务感知注意力模块被部署在通道维度上,通过学习不同卷积核的响应,使不同特征通道能够分别支持不同的任务。这种方法不仅提高了模型的灵活性,还显著提升了检测精度和效率。

在具体实现中,任务感知注意力模块通常与其他注意力机制(如尺度感知注意力和空间感知注意力)结合使用。例如,在DyHead中,尺度感知注意力模块负责学习特征图的尺度变化,空间感知注意力模块负责学习特征图的空间位置变化,而任务感知注意力模块则负责动态调整通道特征的重要性。

任务感知注意力的优势

- 自适应性:任务感知注意力能够根据任务需求动态调整注意力分配,从而提高模型对特定任务的适应能力。

- 灵活性:通过动态调整通道特征的重要性,任务感知注意力能够支持多种任务类型,如目标检测、分类和回归等。

- 性能提升:实验表明,引入任务感知注意力机制后,模型在目标检测等任务中的性能显著提升。例如,YOLOv8通过引入DyHead检测头,在COCO基准测试中取得了显著的性能提升。

实现细节

在实际应用中,任务感知注意力模块通常通过以下步骤实现:

- 特征提取:首先从输入特征金字塔中提取多层特征。

- 注意力计算:通过全局平均池化对特征进行降维,然后通过全连接层和归一化层对特征进行处理。

- 动态调整:利用移位的sigmoid函数对输出进行归一化,从而实现对不同通道特征的动态调整。

总结

任务感知注意力是一种强大的注意力机制,通过动态调整注意力分配来优化特定任务的性能。它在目标检测、分类等任务中表现出色,能够显著提高模型的准确性和效率。这种机制的核心在于其自适应性和灵活性,使其成为现代深度学习模型的重要组成部分。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!