交叉熵损失(Cross-Entropy Loss)是一种在机器学习和深度学习中广泛使用的损失函数,主要用于分类问题。其核心思想是衡量模型预测的概率分布与真实标签的概率分布之间的差异性。

交叉熵损失函数基于信息论中的熵概念,特别是相对熵(Kullback-Leibler Divergence)。熵用于描述信息的不确定性,而相对熵则衡量两个概率分布之间的差异。在分类任务中,真实标签通常表示为一个one-hot编码的向量,而模型的预测结果则是一个概率分布。

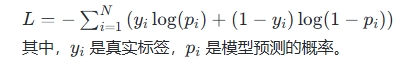

对于二分类问题,交叉熵损失函数可以表示为:

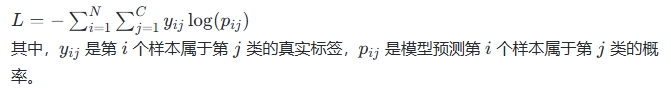

对于多分类问题,交叉熵损失函数通常与softmax函数结合使用,以将模型输出转换为概率分布。在这种情况下,损失函数可以表示为:

交叉熵损失函数的优势在于它能够有效地处理多类分类问题,并且在反向传播过程中具有良好的梯度性质,这使得它成为许多深度学习框架中的默认损失函数。此外,交叉熵损失函数通过最大化正确类别的输出并最小化其他类别的输出,提高了模型的分类性能

交叉熵损失函数的优势在于它能够有效地处理多类分类问题,并且在反向传播过程中具有良好的梯度性质,这使得它成为许多深度学习框架中的默认损失函数。此外,交叉熵损失函数通过最大化正确类别的输出并最小化其他类别的输出,提高了模型的分类性能

声明:文章来源于网络,如有侵权请联系删除!